Крупкина Т.В. Математическая статистика

Подождите немного. Документ загружается.

α = 0, 05.

t

∗

= χ

2

l−r−1; 0,95

= χ

2

3−0−1; 0,95

= χ

2

2; 0,95

= 5, 99

(последнее значение нашли по таблице).

Z

в

< t

∗

,

следовательно, гипотезу H

0

не отвергают.I

16.4. Проверка гипотезы однородности: критерий Колмогорова –

Смирнова

Теорема 16.3 (теорема Смирнова). Пусть F

n

(x) и F

m

(x) – две эмпири-

ческие функции, построенные на основе двух независимых выборок

объемов n и m из одного и того же распределения F

ξ

, и

D

n,m

= sup

−∞<x<∞

|F

n

(x) − F

m

(x)|. (122)

Тогда если теоретическая функция F (x) непрерывна, то для любого

фиксированного t > 0

lim

n,m→∞

P (|

p

nm/(n + m)D

n,m

6 t| = K(t), (123)

где функция K(t) определена равенством (116).

Эта теорема позволяет ответить на важный практический вопрос,

можно ли считать, что две выборки получены из одного и того же распреде-

ления.

Есть две выборки X = (X

1

, . . . , X

n

) и Y = (Y

1

, . . . , Y

m

), причем

X

i

∈ F

x

, Y

i

∈ F

y

, и распределения F

x

, F

y

, вообще говоря, неизвестны. Про-

веряется сложная гипотеза H

0

: F

x

= F

y

против альтернативы H

1

: F

x

6= F

y

.

Если F

x

, F

y

имеют непрерывные функции распределения, применим

критерий Колмогорова – Смирнова.

Пусть F

n,x

и F

m,y

– эмпирические функции распределения, построен-

ные по выборкам X и Y ,

Z(X, Y ) =

r

nm

n + m

max

t

|F

n,x

(t) − F

m,y

(t)|.

Если гипотеза H

0

верна, то Z(X, Y ) ⇒ ξ ∈ K (распределение, имею-

щее функцию распределения Колмогорова) при n, m → ∞.

151

Замечание 16.2. Если верна гипотеза H

1

, то Z(X, Y )

p

−→ ∞ при

n, m → ∞.

Если случайная величина ξ имеет функцию распределения K(y), то

по заданному α найдем C такое, что α = P(ξ > C). Построен критерий

согласия Колмогорова – Смирнова:

H

d

=

H

0

, Z(X, Y ) < C;

H

1

, Z(X, Y ) > C.

Если число выборок больше двух, то для проверки гипотезы однород-

ности можно пользоваться одним из вариантов критерия χ

2

Пирсона

44

.

16.5. Проверка гипотезы независимости: критерий χ

2

Пирсона

Не волнуйся, голова!

Теперь будет думать компьютер.

Гомер Симпсон

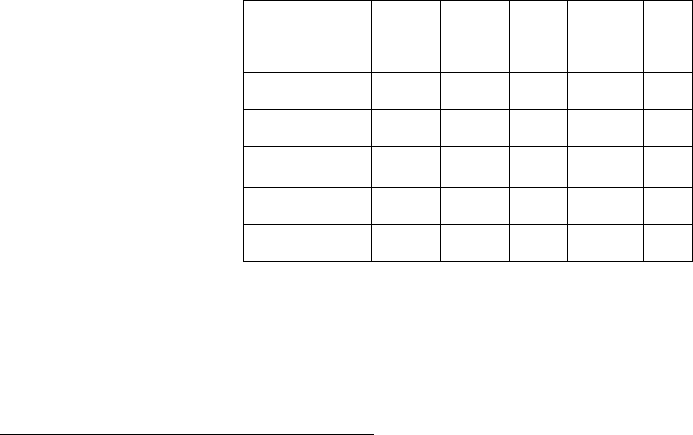

По выборке (X, Y ) = ((X

1

, Y

1

), . . . , (X

n

, Y

n

)) значений двух наблюда-

емых совместно величин ξ и η в n экспериментах будем проверять гипотезу

H

0

: ξ и η независимы.

Сгруппируем значения ξ в k интервалов, а значения η в m интерва-

лов и подсчитаем эмпирические частоты для каждого интервала двумерной

группировки (i = 1, . . . , k, j = 1, . . . , m).

(Здесь µ

i,j

– число пар (X, Y ), попавших в клетку δ

x

i

× δ

y

j

, и т. д.)

Y δ

y

1

δ

y

2

. . . δ

y

m

Σ

X

δ

x

1

µ

1,1

µ

1,2

. . . µ

1,m

b

1

δ

x

2

µ

2,1

µ

2,2

. . . µ

2,m

b

2

.

.

. . . .

δ

x

k

µ

k,1

µ

k,2

. . . µ

k,m

b

k

Σ a

1

a

2

. . . a

m

n

Если гипотеза H

0

верна, то теоретические вероятности попадания па-

ры (X

1

, Y

1

) в любую из областей δ

x

i

×δ

y

j

равны произведению вероятностей:

p

i,j

= P((X

1

, Y

1

) ∈ δ

x

i

× δ

y

j

) = P(X

1

∈ δ

x

i

)P(Y

1

∈ δ

y

j

) = p

x

i

p

y

j

,

44

Критерий Пирсона применяется для проверки разных гипотез – согласия, однородности, независимости.

152

и по ЗБЧ частоты должны быть близки к вероятностям:

b

i

n

≈ p

x

i

,

a

j

n

≈ p

y

j

,

µ

i,j

n

≈ p

i,j

.

Статистикой критерия служит функция, учитывающая различия меж-

ду µ

i,j

и

b

i

a

j

n

:

Z(X, Y ) = n

k

X

i=1

m

X

j=1

(µ

i,j

− (b

i

a

j

)/n)

2

b

i

a

j

= n

k

X

i=1

m

X

j=1

µ

2

i,j

b

i

a

j

− 1

!

.

Поэтому значительная разница может служить основанием для отклонения

гипотезы независимости. Если гипотеза H

0

верна, то Z(X, Y ) ⇒ χ

2

(k−1)(m−1)

при n → ∞.

16.6. Контрольные вопросы

1. Что такое критерий согласия?

2. Изложите схему построения критерия согласия.

3. Можно ли проверить гипотезу о виде распределения с помощью

параметрического критерия?

4. Дайте определение критерия асимптотического уровня α.

5. Какую гипотезу проверяет критерий согласия Пирсона?

6. Какая статистика используется в критерии согласия Пирсона?

7. Какую гипотезу проверяет критерий согласия Колмогорова?

8. Какая статистика используется в критерии согласия Колмого-

рова?

9. Каковы ограничения на статистическую модель и выборку для

применения критериев согласия Пирсона и Колмогорова?

10. Сформулируйте теорему Колмогорова.

11. Сформулируйте теорему Гливенко – Кантелли.

12. Сформулируйте теорему Смирнова.

13. Какую гипотезу проверяет критерий Колмогорова – Смирнова?

153

14. Для каждого из трех текстов имеются данные о частотах, с

которыми встречаются в тексте различные служебные слова и

знаки препинания. Какой критерий можно применить для про-

верки содержательной гипотезы: «Эти три текста принадле-

жат одному автору»?

15. В условиях предыдущего вопроса какую статистику можно ис-

пользовать для проверки содержательной гипотезы: «Эти три

текста принадлежат одному автору»?

16. Датчик случайных чисел выдал N чисел 0, 1, . . . , 9. Среди них чис-

ло i встречалось n

i

раз (n

0

+. . .+n

9

= N). Как проверить гипотезу

о случайности чисел?

154

Лекция 17. Оценка параметров уравнения регрессии

Все модели неправильны,

но некоторые полезны.

Джордж Бокс

План лекции: метод наименьших квадратов, общая модель ли-

нейной регрессии, свойства оценок метода наименьших квадра-

тов, нормальная регрессия.

17.1. Метод наименьших квадратов

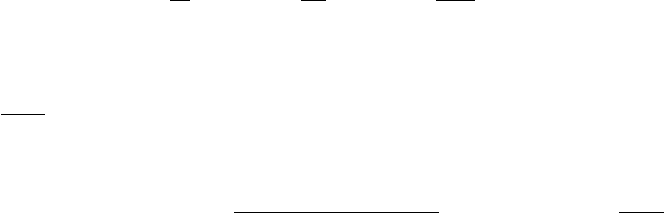

Пусть Y – случайная величина, X

i

, i = 1, . . . , k – контролируе-

мые (неслучайные) переменные. При этом значения величины Y зависят не

только от значений X

i

, но и от других факторов, в том числе таких, которые

не поддаются контролю. Поэтому для фиксированного значения X

∗

вели-

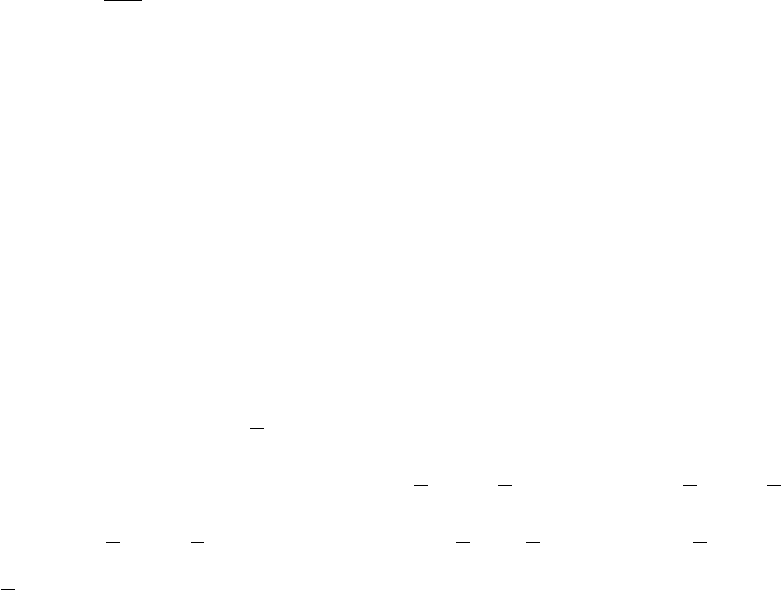

чина Y подвержена некоторому разбросу (рис. 9).

Y

XO

Рис. 9. Данные для отыскания регрессионной зависимости

Модель (функциональная зависимость) известна из предварительных

соображений с точностью до параметров:

Y = f(X

1

, . . . , X

k

, θ

1

, . . . , θ

s

) + ε,

где θ

i

, i = 1, . . . , s – параметры, ε – вектор ошибок.

Набор данных имеет вид

Y

1

= f(X

11

, . . . , X

1k

, θ

1

, . . . , θ

s

) + ε

1

,

. . .

Y

n

= f(X

n1

, . . . , X

nk

, θ

1

, . . . , θ

s

) + ε

n

,

где X

ij

– значение j-й переменной при i-м измерении. Будем считать, что

E ε = 0 и ошибки некоррелированы: K

ε

= cov

ε

= E(εε

T

) = σ

2

E

n

.

155

По методу наименьших квадратов (МНК) оценки параметров выби-

раются так, чтобы минимизировать сумму квадратов ошибок, то есть оце-

ниваются из условия

R =

P

n

i=1

(Y

i

− f(X

i1

, . . . , X

ik

, θ

1

, . . . , θ

s

))

2

→ min,

∂R

∂θ

j

= 0, j = 1, . . . , s.

Линия Y = f(X

1

, . . . , X

k

, θ

1

, . . . , θ

s

) называется линией регрессии Y

на X

45

.

17.2. Общая модель линейной регрессии

Наиболее часто используются линейные по параметрам модели вида

Y = θ

1

· a

1

(X

1

) + θ

2

· a

2

(X

2

) + . . . + θ

k

· a

k

(X

k

) + ε.

(Если a

k

(X

k

) ≡ 1, будет свободный член.)

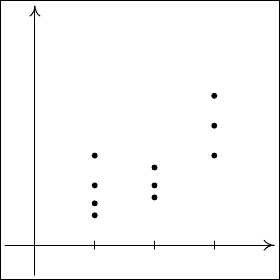

Рассмотрим основной случай, когда a

i

(X

i

) = X

i

. Одномерный случай

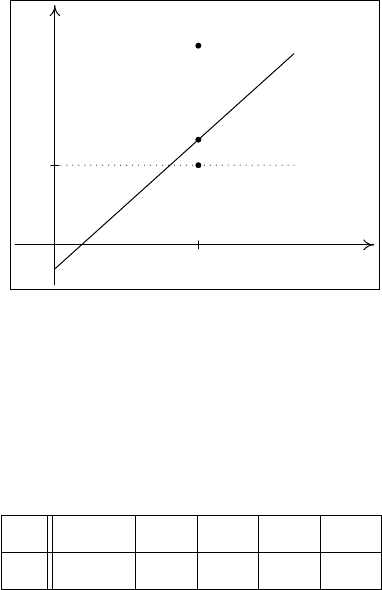

(k = 1) представлен на рис. 10.

Y

XO

ε

i

Рис. 10. Иллюстрация модели линейной регрессии

В общем случае исходные данные имеют вид

Y

1

= X

11

θ

1

+ . . . + X

1k

θ

k

+ ε

1

. . .

Y

n

= X

n1

θ

1

+ . . . + X

nk

θ

k

+ ε

n

или Y = X · θ + ε,

45

Термин «регрессия» введен Ф. Гальтоном (1886). Он установил, что особенности роста родителей про-

являются и у их детей, но в среднем в меньшей степени. У родителей низкого или высокого роста рост детей

оказывается несколько ближе к среднему, то есть (в среднем) у низких дети выше, а у высоких родителей –

ниже. Гальтон назвал это явление «возвратом» (regression).

156

где

Y =

Y

1

.

.

.

Y

n

, X =

X

11

. . . X

1k

.

.

.

.

.

.

.

.

.

X

n1

. . . X

nk

, ε =

ε

1

.

.

.

ε

n

.

Кроме того, E ε = 0, E(εε

T

) = σ

2

E

n

.

Сумма квадратов ошибок или остаточная дисперсия

R = K(θ) =

X

(Y

i

−

k

X

j=1

X

ij

θ

j

)

2

→ min,

что эквивалентно

R = (Y − Xθ)

T

(Y − Xθ) → min .

Предположим, что матрица X

T

X не вырождена и найдем оценку θ из усло-

вия

∂R

∂θ

l

= −2

n

X

i=1

X

il

(Y

i

−

X

X

ij

θ

j

) = 0, l = 1, . . . , k.

Имеем

X

T

(Y − Xθ) = 0 ⇐⇒ X

T

Y = X

T

Xθ ⇐⇒

ˆ

θ = (X

T

X)

−1

· X

T

Y.

Уравнение X

T

Xθ = X

T

Y называется нормальным уравнением метода

наименьших квадратов, а

ˆ

θ = (X

T

X)

−1

· X

T

Y – оценкой параметров ли-

нейной регрессии методом наименьших квадратов (о.н.к.).

Теорема 17.1. Пусть

ˆ

θ – любое решение нормального уравнения. То-

гда min R(θ) = R(

ˆ

θ). Если |X

T

X| 6= 0, то о. н. к. единственна и равна

ˆ

θ = (X

T

X)

−1

· X

T

Y .

Доказательство. Пусть θ – произвольное фиксированное значение θ; тогда

R(θ) = (Y −Xθ)

T

(Y −Xθ) = [Y −Xθ + X(θ −θ)]

T

[Y −Xθ + X(θ −θ)] =

= R(θ) + 2(θ − θ)

T

(X

T

Y − X

T

Xθ) + (θ − θ)

T

X

T

X(θ − θ).

При θ =

ˆ

θ = (X

T

X)

−1

· X

T

Y средний член обращается в 0 и

R(θ) = R(

ˆ

θ) + (

ˆ

θ − θ)

T

X

T

X(

ˆ

θ − θ) > R(

ˆ

θ), (124)

так как матрица X

T

X неотрицательно определена. Равенство достигается

при θ =

ˆ

θ, следовательно, это и есть точка минимума. Единственность сле-

дует из однозначной разрешимости нормального уравнения при невырож-

денной матрице X

T

X .

157

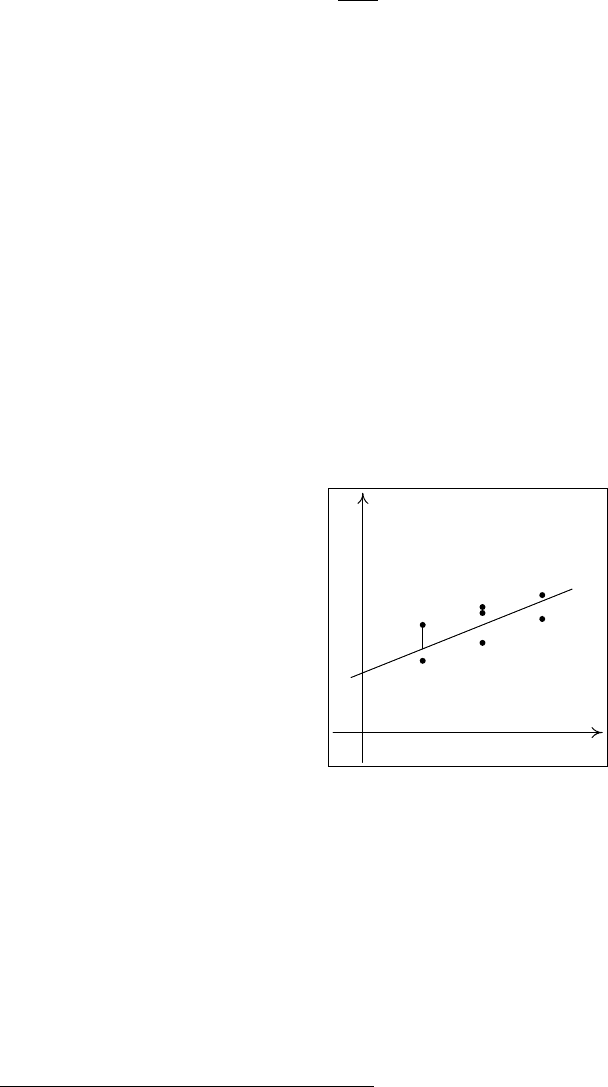

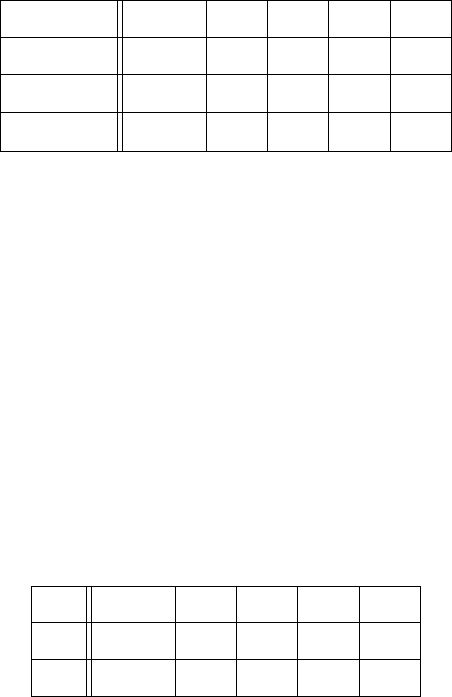

На рис. 11 изображена расчетная линия регрессии ˆy = a

0

+ a

1

x, сред-

нее значение зависимой переменной y и три точки, соответствующие задан-

ному значению переменной x

i

: наблюдаемое значение y

i

, вычисленное по

регрессии ˆy

i

= a

0

+ a

1

x

i

, и среднее значение ¯y.

Y

XO

ˆy=a

0

+a

1

x

x

i

¯y

ˆy

i

y

i

¯y

Рис. 11. Фактическое, расчетное и среднее значения зависимой переменной y

Пример 17.1. Найдем оценку параметра линейной модели Y = X ·θ+ε

по данным:

X 0 1 2 3 4

Y −1, 2 0, 1 3, 0 4, 9 7, 3

.

J Напомним, что X и Y в формулах – это векторы-столбцы (как бы

ни были они заданы в условиях).

ˆ

θ = (X

T

X)

−1

· X

T

Y.

X

T

X =

0 1 2 3 4

·

0

1

2

3

4

= 30;

X

T

Y =

0 1 2 3 4

·

−1, 2

0, 1

3, 0

4, 9

7, 3

= 50;

ˆ

θ = (X

T

X)

−1

· X

T

Y = 5/3;

ˆ

Y = 5/3X ≈ 1, 7X.

I

158

Пример 17.2. Найдем в условиях предыдущего примера величину

ˆ

R,

равную сумме квадратов ошибок.

J

ˆ

R =

X

i

(Y

i

−

ˆ

θX

i

)

2

=

X

i

(Y

i

−

ˆ

Y

i

)

2

,

где

ˆ

Y

i

– значения, вычисленные по уравнению регрессии

ˆ

Y = 1, 7X.

X 0 1 2 3 4

Y −1, 2 0, 1 3, 0 4, 9 7, 3

ˆ

Y 0 1, 7 3, 4 5, 1 6, 8

|Y −

ˆ

Y | 1, 2 1, 6 0, 4 0, 2 0, 5

.

ˆ

R =

X

i

(Y

i

−

ˆ

Y

i

)

2

= 4, 45.

I

Пример 17.3. Найдем по данным примера 17.1 оценки параметров ли-

нейной модели

Y = X ·θ + θ

1

+ ε.

J Будем считать, что переменная X двумерна, и рассматривать модель Y =

X

1

· θ + X

2

θ

1

+ ε, где X

2

≡ 1.

X

1

0 1 2 3 4

X

2

1 1 1 1 1

Y −1, 2 0, 1 3, 0 4, 9 7, 3

.

ˆ

θ = (X

T

X)

−1

· X

T

Y.

X

T

X =

30 10

10 5

; (X

T

X)

−1

= 1/50 ·

5 −10

−10 30

=

0, 1 −0, 2

−0, 2 0, 6

.

X

T

Y =

0 1 2 3 4

1 1 1 1 1

·

−1, 2

0, 1

3, 0

4, 9

7, 3

=

50

14, 1

.

ˆ

θ = (X

T

X)

−1

· X

T

Y =

0, 1 −0, 2

−0, 2 0, 6

·

50

14, 1

=

2, 18

−1, 54

;

159

ˆ

Y = 2, 18X − 1, 54.

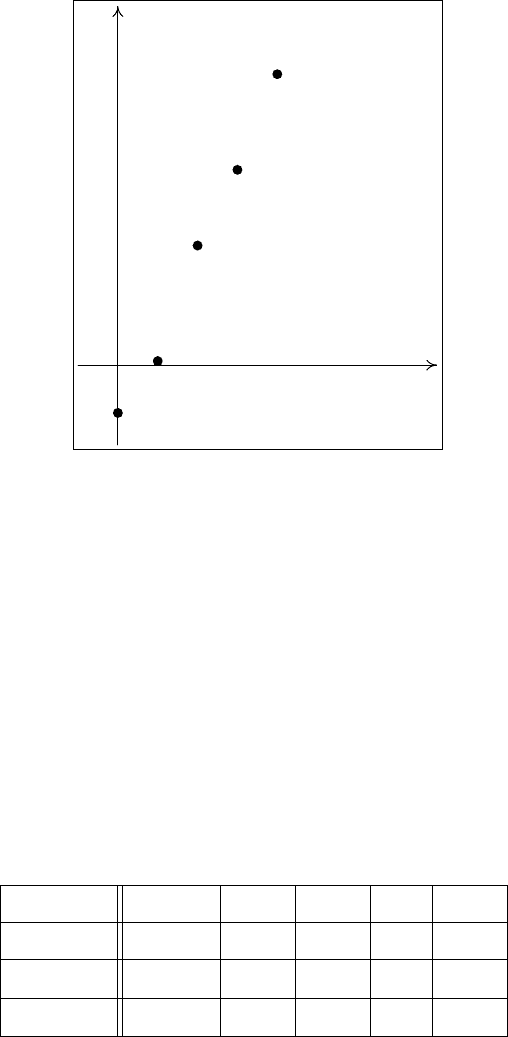

O

Y

X

Рис. 12. Графическое изображение данных (примеры 17.1–17.3)

Найдем для этой модели величину

ˆ

R, равную сумме квадратов оши-

бок:

ˆ

R =

X

i

(Y

i

−

2

X

j=1

X

ij

θ

j

)

2

=

X

i

(Y

i

−

ˆ

Y

i

)

2

,

где

ˆ

Y

i

– значения, вычисленные по уравнению регрессии

ˆ

Y = 2, 18X −1, 54

(рис. 12).

X 0 1 2 3 4

Y −1, 2 0, 1 3, 0 4, 9 7, 3

ˆ

Y −1, 54 0, 64 2, 82 5 7, 18

|Y −

ˆ

Y | 0, 34 0, 54 0, 18 0, 1 0, 12

.

ˆ

R =

X

i

(Y

i

−

ˆ

Y

i

)

2

= 0, 4640.

Как видим, ошибка при использовании модели со свободным членом

примерно в 10 раз меньше. Причина этого понятна из рис. 12. Очевидно,

модель без свободного члена (Y = X ·θ + ε) не является адекватной. I

В одномерном случае для нахождения параметров линейной модели

Y = X ·θ +θ

1

+ε удобно использовать следующие формулы, получаемые из

160